개념 : 데이터 분석의 기본

- 정확하고 신뢰 할 수 있는 데이터 마이닝 결과를 추출하기 위하여 데이터의 분석 및 처리에 적합한 형식으로 데이터를 조작하는 과정

- 올바른 분석 결과를 얻기 위해서는 올바른 데이터를 입력해야 하므로, 우수한 분석 알고리즘을 설계하는 것만큼이나 충분히 가다듬어진 데이터를 확보하는 것이 중요

- 값/분류 인코딩, 샘플링, 스케일링, 피처추출을 통해 머신러닝이 학습하기 편하고, 오버피팅 최소화하는 것이 전처리의 목적

데이터 전처리 단계

- 데이터 분석을 위해서는 그에 적합한 데이터가 필요하며, 이를 확보하기 위해 충분한 데이터 전처리(Data Preparation) 과정이 필수적임

- 데이터 전처리는 모델링에 적합한 형태로 처리하는 과정으로, 데이터를 정규화 하거나, 다른 형태로 변화하거나 결측값을 대체하는 작업을 진행

| 단계 | 설명 | 기법 |

| 데이터 정제 (cleansing) |

|

|

| 데이터 통합 (integration) |

|

|

| 데이터 변환 (transformation) |

|

|

| 데이터 정리 (reduction) |

|

|

- 대용량 데이터의 전처리 과정은 사람이 정제 및 정형을 하기에 한계가 있어 데이터의 형태 및 구조를 파악하여 작업을 용이하게 하는 데이터 전처리 툴 필요

전처리 기법

| 구분 | 전처리 기법 | 설명 |

| 결측값 다루기 | 샘플 및 피처 제거 | - 결측값이 있는 행이나 열을 제거 - 너무 많은 제거는 가치 있는 정보의 손실 유발 |

| 결측값 보정 | - 일반적으로 보간법 사용 - 평균값, Median값, 최빈값 등으로 대치 |

|

| 범주형 데이터 다루기 |

명목형/순서형 피처 매핑 | - 명목형 피처를 정수형으로 매핑(크기 무의미) - 순위형 피처를 정수형으로 매핑(크기 의미 있음) |

| 분류 라벨 인코딩 | - 명목형 분류라벨을 정수형으로 인코딩 | |

| 명목형 피처 원핫 인코딩 | - 명목형 피처를 수치화하면 머신러닝은 순위형으로 오해 - 원핫 인코딩으로 명목형 피처를 Dummy 피처로 대체하여 해결 |

|

| 피처 스케일링 | 정규화 | - 데이터를 0과 1 범위로 스케일링 - 최대 최소 스케일링의 특별한 케이스 |

| 표준화 | - 평균 0, 표준편차 1이 되도록 피처 열을 중심화 - 표준화 후 피처 열은 정규분포 형태를 가짐. |

|

| 피처 선택 | L1 정규화가 있는 희소 솔루션 찾기 |

- 훈련데이터의 비용함수를 최소화하는 가중계수 조합 찾기 - 가중계수가 작은 피처를 제거 |

| 그리드 서치 알고리즘 | - 연속형 피처 선택 알고리즘으로 사용 - 단계별 지역 최적해 도출 후, 문제에 대한 최적해 도출기법 |

|

| 랜덤 포레스트 | - 피처의 상대적 중요도를 다수의 의사결정 트리로 구성 - 이를 조합하여 피처 중요도 평가 |

|

| 차원 축소 | 주성분 분석(PCA) | - 데이터 내 최대 분산 수직 축을 찾으려는 비지도적 선형변환 기법 - 변환행렬 이용하여 X1, X2 차원을 PC1, PC2 차원으로 변환 |

| 선형 판별 분석(LDA) | - 분류의 분리를 최적화하는 지도적 차원축소 기법 - 피처간 통계적 상호독립성, 분류간 동일한 공분산 행렬, 피처 내 데이터의 정규분포를 가정한 상태에서 정규분포 패턴의 차이를 분류하는 방식 |

'메가노트 > 토픽과제(정리)' 카테고리의 다른 글

| Cross Validation(문경숙 수석님) (0) | 2022.10.29 |

|---|---|

| SVM(유준수 사장님) (0) | 2022.10.29 |

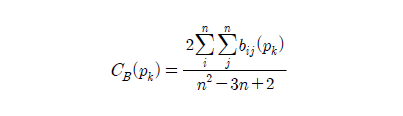

| 중심성 평가(이재용 부장님) (0) | 2022.10.29 |

| 데이터 통합 및 마이그레이션(김도현 부장님) (0) | 2022.10.29 |

| 마이데이터(홍진택 주무관님) (0) | 2022.10.29 |